Parece que cada semana recibimos dos o tres noticias que por sí solas tendrían el potencial de acaparar los titulares regulares de un año normal. La última actualización de ChatGPT.

Recientemente, la compañía detrás de ChatGPT, OpenAI, anunció que había agregado soporte para una docena de complementos de aplicaciones para mejorar y extender la funcionalidad del super chatbot.

En esta publicación, discutiremos en detalle cada uno de los complementos de aplicaciones agregados recientemente a ChatGPT, así como también proporcionaremos información adicional sobre las capacidades de la plataforma en general.

Primero un poco de historia sobre ChatGPT.

ChatGPT es una herramienta de lenguaje natural avanzada que utiliza técnicas de procesamiento del lenguaje natural para comprender el lenguaje humano y generar respuestas coherentes y precisas. La plataforma es utilizada por una amplia gama de industrias, incluyendo el servicio al cliente, la atención médica, mercadeo, investigación, educación, programación y muchas más.

Chat GPT que fuera lanzada apenas en Noviembre de 2023. Mientras que a Facebook le tomó 8 años llegar a la marca de 100 millones de usuario, a Instagram 2 y a Tik Tok tan solo 9 meses, ChatGPT logró hacerlo en tan solo 60 días. Desde puntos de vista de objetivos, mercadeo y aceptación de tecnologías la respuesta que ha tenido ChatGPT es simplemente impresionante. Y a tan solo 4 meses de su lanzamiento gratuito ya contaba un plan Premium de $20 para garantizar un desempeño superior a sus versión gratuita.

Mientas que proyectos como Google, Amazon y Facebook debieron dejar pasar años hasta poder crear modelos de negocios viables para su empresa, la mayoría de ellos basados en publicidad.

La verdad es que cuando ChatGPT se lanzó, era aún una versión Beta, la idea de Open AI era poder medir el desempeño del bot y recibir Feedback de sus usuarios, sobre errores, mejorías o faltas lógicas en el modelo, al mismo tiempo que el bot se alimentaba de interacciones a tiempo real con humanos. Uno de los mayores poblemas o barreras del Chat bot era que había sido entrenado con los datos web presentes hasta el año 2021. Es decir que el Chatbot no se encontraba en capacidad de navegar por internet, ni de interacturar con sitios web o presentar información ocurrida después de 2021.

ChatGPT y su API

Open AI también liberó un API para ChatGPT que permitía que cualquier persona pudiera crear una conexión directa con el bot a través de una interfaz.

Las siglas “API” significan “Interfaz de Programación de Aplicaciones” (en inglés, “Application Programming Interface”). En términos generales, una API es un conjunto de protocolos, funciones y herramientas que se utilizan para diseñar y desarrollar software, permitiendo la comunicación entre distintas aplicaciones.

En otras palabras, una API permite que una aplicación se comunique con otra, de modo que puedan intercambiar datos o utilizar funcionalidades específicas. Esto se logra al definir una serie de reglas claras y sencillas que permiten la interacción entre diferentes sistemas o aplicaciones. Por ejemplo aplicaciones como Uber desarrollan una infraestructura y software que se conecta de manera exclusiva a Google Maps y de donde obtienen datos de navegación. Sin embargo Uber no es propietaria de Google Maps y cualquier cambio en las políticas de uso de Google Maps podría poner en serios problemas a Uber.

El acceso a esta API de GPT, hizo de centenares de personas y compañías diseñaran su propio software para integrar las capacidades de GPT en sus empresa. Es decir, ahora miles de pequeñas aplicaciones podían explotar a distancia los beneficios y el potencial de ChatGPT. Por un costo minúsculo y por varios meses la impresión era que se iniciaba una nueva carrera armamentista de creación de aplicaciones que explotaran las capacidades de Open AI y los poderosos servidores de Microsoft sin necesidad de incurrir en gastos de imposibles de financiar. Es decir la (en apariencia) más poderosa inteligencia artificial hasta el momento se empezaba a “democratizar”.

¿Qué son los Plug ins?

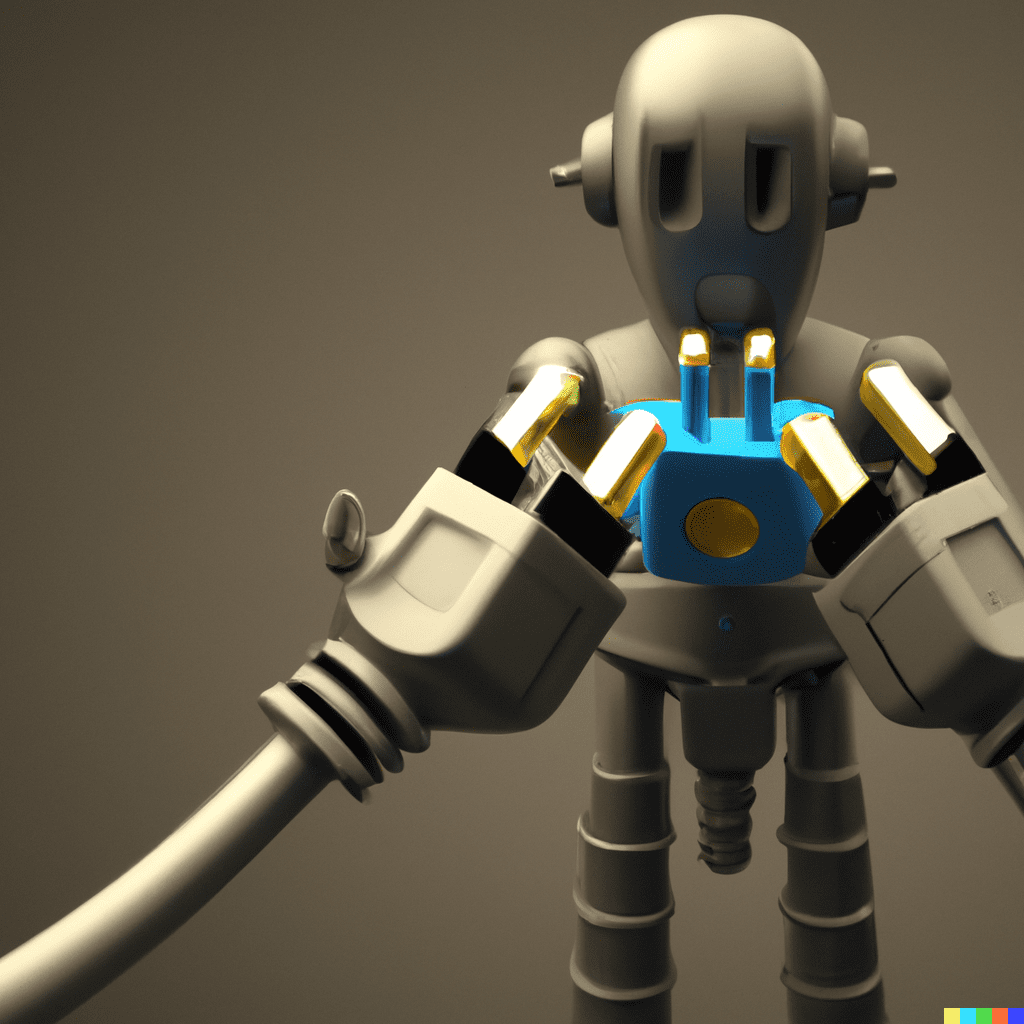

La traducción literal de la palabra Plug In es un “conector” o “enchufe eléctrico” que al conectarse a las capacidades de una plataforma adquiere la capacidad de extender las capacidades de dicha plataforma. Por ejemplo el repositorio de Plug Ins de la plataforma WordPress es de más de 50.000 plug ins, pequeños programas desarrollados para integrarse y trabajar de manera precisa con el software original. Hasta aquí podemos decir que los objetivos de los plug ins y de los APIs es muy similar.

La diferencia se da en la independencia del funcionamiento de cada uno. Mientras un código API, permite que el potencial del programa original se ejecute en un ambiente ajeno al del programa original, los plug ins solo son útiles dentro del ambiente y programa original.

Dicho de otra palabra un Plug ins de WordPress no puede funcionar en Shopify, Wish o Webflow. Pero el API de Google Maps si puede funcionar en todas estas y otras muchas aplicaciones. Es decir los Plug ins funcionan por naturaleza en un ambiente cerrado.

¿Una plataforma más que un Chatbot?

Integrar Plug ins dentro de la experiencia de Usuario de ChatGPT consolida a ChatGPT como una plataforma, es decir, una serie de habilidades, funciones y potenciales se suman a las capacidades del ChatGPT y cada vez es menos necesario salir de de ChatGPT para ejecutar comandos, interactuar con internet e incluso hacer compras.

La creación de Plug Ins se ha convertido en una verdadera industria, en decenas de plataformas y programas, permitiendo que personas y empresas generen actividades lucrativas y se involucren en procesos de mejoras constantes que a su vez aumetan el atractivo y potencial de la plataforma original. El hecho de la habilitar la participación de terceros en la creación y oferta de plug ins, implica la posibilidad de competencia en terceros en un mismo sector. Esto descadena en la exisitencia de tiendas y verdaderas economías SaaS que gravitan al rededor de la plataforma matriz.

Los Plug ins.

El 23 de Marzo el Blog oficial de Chat GPT hizo público el anuncio de la opción a incorporar plug ins para sus usuarios de pago, esta función sin embargo permanece en versión Alpha y requiere invitación directa, por lo que aún no se encuentra abierta al público. Según el blog se empezará con un pequeño grupo de usuarios y se irá ampliando el acceso a medida que se aprenda más. Los desarrolladores pueden utilizar la documentación proporcionada para crear plugins, y las primeras empresas que han creado plugins son:

El objetivo es construir una comunidad que moldee el futuro de la interacción humano-AI.

Open AI está además alojando dos complementos propios un navegador web e intérprete de código. También hemos abierto el código fuente de un complemento de recuperación de base de datos, para que cualquier desarrollador pueda alojarlo en su servidor ChatGPT. Abajo podrás unirte a la lista de espera de los Plug Ins y también ver un video que demuestra algunas de las funcionalidades de los nuevos plug ins.

Para agregarse a la lista de espera haga clic en el botón

Ahora, con la adición de una docena de nuevos complementos de aplicaciones, ChatGPT se ha vuelto aún más versátil y capaz de manejar una variedad aún mayor de casos de uso. Estos complementos incluyen:

¿Qué implican los plug ins según Open AI?

Los modelos de lenguaje actuales, aunque útiles para una variedad de tareas, siguen siendo limitados. La única información que pueden aprender proviene de sus datos de entrenamiento. Esta información puede estar desactualizada y es única para todas las aplicaciones. Además, lo único que los modelos de lenguaje pueden hacer de manera predeterminada es emitir texto. Este texto puede contener instrucciones útiles, pero para seguir estas instrucciones se necesita otro proceso.

Aunque no es una analogía perfecta, los complementos o plug ins pueden ser “ojos y oídos” para los modelos de lenguaje, dándoles acceso a información que es demasiado reciente, demasiado personal o demasiado específica para ser incluida en los datos de entrenamiento. En respuesta a una solicitud explícita del usuario, los complementos también pueden permitir que los modelos de lenguaje realicen acciones seguras y limitadas en su nombre, aumentando la utilidad del sistema en general.

Open AI espera que surjan estándares abiertos para unificar las formas en que las aplicaciones exponen una interfaz orientada a la inteligencia artificial. Estamos trabajando en un intento temprano de lo que podría parecer dicho estándar, y estamos buscando.

Los riesgos de la apertura a Plug Ins de terceros.

El objetivo de incorporación de Plug ins es motivar la colaboración con otras empresas y desarrolladores para mejorar la eficacia y el valor de la tecnología de lenguaje natural.

Los modelos de lenguaje actuales son útiles para muchastareas, pero tienen limitaciones porque solo pueden aprender de los datos de entrenamiento disponibles, que pueden estar desactualizados y no ser aplicables a todas las situaciones. Además, solo pueden emitir texto, no puede por ejemplo realizar compras o reservas mesas en un restaurante. Sin embargo, los complementos pueden ser una solución para otorgar a los modelos de lenguaje acceso a información más actualizada, personal y específica. Estos complementos también pueden permitir que los modelos de lenguaje realicen acciones útiles y seguras a nombre del usuario, mejorando la utilidad del sistema.

La conexión de modelos de lenguaje a herramientas externas presenta nuevas oportunidades, así como nuevos riesgos significativos.

Los complementos ofrecen el potencial para abordar varios desafíos asociados con los modelos de lenguaje grandes, incluidas las “alucinaciones”, mantenerse al día con los eventos recientes y acceder (con permiso) a fuentes de información patentadas. Al integrar el acceso explícito a datos externos, como información actualizada en línea, cálculos basados en códigos o información recuperada de complementos personalizados, los modelos de lenguaje pueden fortalecer sus respuestas con referencias basadas en evidencia.

Estas referencias no solo mejoran la utilidad del modelo, sino que también permiten a los usuarios evaluar la confiabilidad de los resultados del modelo y verificar su precisión, mitigando potencialmente los riesgos relacionados con el exceso de confianza, como se analiza en nuestra tarjeta de sistema GPT-4 reciente. Por último, el valor de los complementos puede ir mucho más allá de abordar las limitaciones existentes al ayudar a los usuarios con una variedad de nuevos casos de uso, que van desde navegar por catálogos de productos hasta reservar vuelos o pedir comida.

Al mismo tiempo, existe el riesgo de que los complementos puedan aumentar los desafíos de seguridad al tomar acciones dañinas o no intencionadas, aumentando las capacidades de los malos actores que defraudarían, engañarían o abusarían de otros. Al aumentar la gama de posibles aplicaciones, los complementos pueden aumentar el riesgo de consecuencias negativas por acciones erróneas o desalineadas que realiza el modelo en nuevos dominios. Desde el primer día, estos factores han guiado el desarrollo de nuestra plataforma de complementos y hemos implementado varias medidas de seguridad.

Peligros y mitigaciones.

Open AI reporta haber llevado a cabo ejercicios de red-teaming tanto internamente como con colaboradores externos, que han revelado posibles escenarios preocupantes. Por ejemplo, los equipos de red-teaming descubrieron formas en que los complementos (plugins), si se publican sin salvaguardas, pueden realizar inyecciones de comando sofisticadas, enviar correos electrónicos fraudulentos y de spam, omitir restricciones de seguridad o utilizar información enviada al complemento de manera inadecuada. Open AI está utilizando estos hallazgos para informar sobre las mitigaciones de seguridad por diseño que restringen los comportamientos arriesgados de los complementos y mejoran la transparencia sobre cómo y cuándo operan como parte de la experiencia del usuario. También se están utilizando estos hallazgos para informar la decisión de Open AI de implementar gradualmente el acceso a los complementos.

¿Qué es red Teaming?

Red teaming is the practice of rigorously challenging plans, policies, systems and assumptions by adopting an adversarial approach. A red team may be a contracted external party or an internal group that uses strategies to encourage an outsider perspective.

Si eres un investigador interesado en estudiar los riesgos o las mitigaciones de seguridad en esta área, Open AI te anima a utilizar su Programa de Acceso para Investigadores. También invitan a los desarrolladores e investigadores a enviar evaluaciones de seguridad y capacidades relacionadas con los complementos como parte de su marco de evaluaciones Evals, que se ha abierto recientemente.

Es probable que los complementos tengan implicaciones sociales de gran alcance. Por ejemplo, recientemente, Open AI publicó un documento de trabajo que encontró que los modelos de lenguaje con acceso a herramientas tendrán impactos económicos mucho mayores que los que no las tienen, y en general, en línea con los hallazgos de otros investigadores, esperamos que la actual ola de tecnologías de inteligencia artificial tenga un gran efecto en el ritmo de la transformación, desplazamiento y creación de empleos. Open AI está deseando colaborar con investigadores externos y clientes para estudiar estos impactos.

Posibles escenarios e implicaciones de los Plug Ins de Chat GPT.

Desde mi perspectiva las mejoras en inteligencia artificial está alcanzando un crecimiento exponencial y no es exageración cuando decimos cada semana recibimos media docena de noticias que encualquier otra época serían por si mismas determinantes para el futuro de internet.

La apertura de una galería de Plug Ins (de seguro muy próximamente tienda) implica que Open Ai y potencialmente su socio mayoritario Microsoft puedan dictar políticas más estrictas con respceto a las condiciones de uso, explotación y beneficios. Escenarios similares se han desarrollado en las apps sotres de Apple y Google. Donde las empresas se pueden permitir cobrar porcentajes de la ganancias y ventas de las apps alojadas, o incluso pueden eliminar apps que compitan o vayan en contra de los intereses de las empresas matrices.

También abre la posibilidad a que la matriz pueda copiar o duplicar las funcionalidades de Plug Ins altamente exitosos de manera nativa.

Desde el lazamiento de los generadores de imágenes por difusión y especialmente desde el lanzamiento de ChatGPT, ha habido una carrera por lanzar nuevas herramientas de Inteligencia Artificial. En un principio Google proponía en lanzamiento de Sparrow de Deep Mind, posteriormente cambió a BARD, luego Bing lanzó Chat Copiloto de búsquedas web un Beta que apenas duró unas semanas antes de ofrecerse como opción a todos sus usuarios. Finalmente logrando asestar un golpe certero a la hegemonia de Google como buscador preferido del planeta. Yo personalmente llevo meses utilizando Merlin y You.com además un plug in para Google Sheets asistido por Open AI.

Mientras tanto otros gigantes tecnologicos como Meta, Amazon y Apple se mantienen silenciosos y expectantes pero podemos dar por un hecho que pronto harán sus movidas.

Una presentación defectuosa de su versión de ChatGPT, hizo que Google perdiera millones de dólares en acciones, es comprensible que otras compañías se tomen su tiempo ates de lanzar versiones definitivas de manera masiva. Sin embargo cada día de espera Open AI genera miles de millones de parámetros y información de interacción. Y se centraliza en la experiencia y memoría de sus usuarios finales.

Quizás igual de sorprendete al paso de desarrollo es la naturalidad con la que el mercado parece tomarse las noticias y avances en AI. Varios momentos pivotales en la historia de internet y que sin duda tendrán un impacto duradero y determinante en la economía de los paises y cosecuentemente del planeta parecen aceptarse con una impasibilidad notable, cual si estos cambios determinantes llevaran años en ejecución constante. Es predecible que este ritmo solo se incrementará y que potencialmente 2022 y 2023 ingresen a los libros de historia como el año de la revoluciónn de la inteligencia artificial.