Introducción

La presencia web es una actividad de mejora constante. Si tu negocio utiliza un sitio web (debería) la lucha por estar siempre en los primeros resultados de Google se conoce como SEO (Search Engine Optimization) [Optimización de Motores de Búsqueda] y es un trabajo complejo pero fascinante, que cuando es bien aplicado puede garantizar el éxito de una empresa frente a su competencia. Una de las mejores estrategias para mantener tu sitio dentro de los primeros resultados en conocer y entender el algoritmo de Google y de los principales motores de búsqueda, y las herramientas que estos usan para presentar los resultados a sus usuarios, que serán tus clientes.

En octubre 2019 Google anunció el que llamó el cambio más importante en su algoritmo en los últimos 5 años. Llamado Bert Update por la comunidad SEO, es uno de los ejes sobre los que gravita la selección de resultados. Aquí te dejamos un poco de información sobre BERT.

¿Qué es Bert?

BERT es un marco de aprendizaje automático de código abierto para el procesamiento del lenguaje natural (NLP). BERT está diseñado para ayudar a las computadoras a comprender el significado del lenguaje ambiguo en el texto mediante el uso del texto circundante para establecer el contexto. El marco BERT se entrenó previamente con texto de Wikipedia y se puede ajustar con conjuntos de datos de preguntas y respuestas.

¿Qué significa BERT?

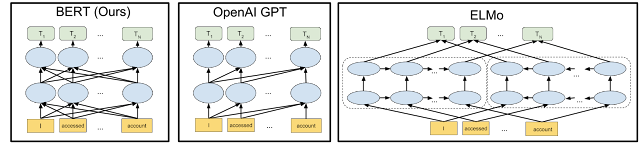

Bidirectional Encoder Representations from Transformers BERT, que en español se puede traducir cómo Representaciones de codificador bidireccional de Transformadores se basa en Transformadores de lenguaje y significado, un modelo de Deep Learing asistido por inteligencia artificial, el que cada elemento de salida está conectado a cada elemento de entrada, y las ponderaciones entre ellos se calculan dinámicamente en función de su conexión. (En PNL, este proceso se llama atención).

Históricamente, los modelos de lenguaje solo podían leer la entrada de texto secuencialmente, ya sea de izquierda a derecha o de derecha a izquierda, pero no podían hacer ambas cosas al mismo tiempo. BERT es diferente porque está diseñado para leer en ambas direcciones a la vez. Esta capacidad, habilitada por la introducción de Transformadores, se conoce como bidireccionalidad.

Usando esta capacidad bidireccional, BERT está pre-entrenado en dos tareas de NLP diferentes, pero relacionadas: modelado de lenguaje enmascarado y predicción de la siguiente oración.

¿Cómo funciona BERT?

El objetivo de cualquier técnica de PNL es comprender el lenguaje humano en sus aplicaciones diarias, cotidianas y ordinarias, es decir tal como se habla de forma natural.

En el caso de BERT, esto normalmente significa predecir una palabra en un espacio en blanco. Para hacer esto, los modelos normalmente necesitan entrenarse usando un gran repositorio de datos de entrenamiento etiquetados y especializados. Esto requiere un complejas y largas jornadas de etiquetado manual de datos por parte de equipos de lingüistas.

Sin embargo al ser BERT una red de Deep Learning fue entrenado por Google haciéndole leer toda la versión en Inglés de Wikipedia, ahorrando horas de ingreso manual de datos y exponiendo al algoritmo a textos de miles de autores y miles de temas diferentes.

En resumen BERT busca comprender el significado de una palabra en relación al texto que la rodea y no solamente basada en su significado literal.

Los resultados del uso de BERT

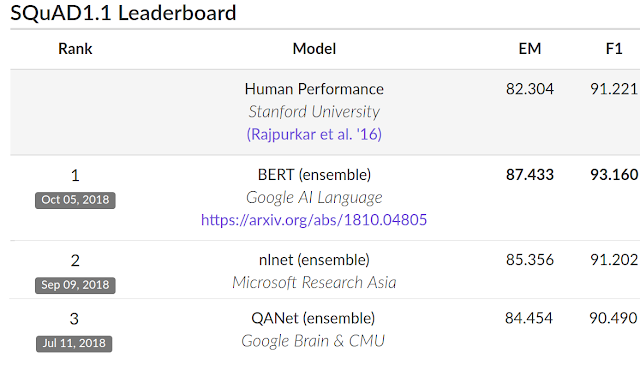

Para evaluar el rendimiento, Google comparó a BERT con otros sistemas NLP de última generación. Es importante destacar que BERT logró todos sus resultados casi sin cambios específicos de tareas en la arquitectura de la red neuronal. En SQuAD v1.1, BERT logró un puntaje F1 del 93,2 % (una medida de precisión), superando el puntaje de vanguardia anterior del 91,6 % y el puntaje a nivel humano del 91,2 %, BERT es por tanto incluso más preciso que los humanos a la hora de realizar predicciones de significados y contextos cuando se presentan textos.

¿Cómo afecta BERT los resultados de busqueda?

La aplicación de BERT no solo afecta al texto en la página de resultados sino también a como comprende Google la consulta que se hace dentro del buscador. La capacidad de lectura por transformadores permite al algoritmo predecir varias opciones de consultas basadas en diferentes niveles de frecuencia y contexto y ayuda a pre-organizar los resultados basado en la consulta final.

Los procesos algorítmicos de BERT son complejos y funcionan utilizando categorizaciones de textos y fragmentándolos en sus componentes (palabras) y creando asociaciones posibles basadas en la frecuencia de estas asociaciones en casos de uso real del lenguaje.

Ejemplo:

“El pollo estaba listo para comer.”

En la frase de arriba no es posible identificar con certeza si el “pollo” había sido cocinado y servido y se podía comer. O si un animal vivo estaba listo para empezar a consumir su alimentos. En el contexto de motores de búsqueda BERT podría enfrentarse a consultas como: “Alistar pollo” “Pollo para comer” “como alistar un pollo” “¿Cuándo sé que el pollo está listo para comer?” “¿Cómo alistar un pollo para comer?” ¿”Cómo preparar pollo para 5 personas”? entre otras.

Varias de las consultas incluyen literalmente las mismas palabras que la frase de ejemplo y algunas contiene sinónimos o literales o funcionares. BERP ayuda a indentificar el conetexto de tanto la frase como la consulta ofreciendo resultados más exactos y con mayor probabilidad de responder de manera correcta.

“Ese es un radio muy grande.”

En la frase de arriba es imposible definir en ella misma la acepción correcta de la palabra radio. Puede referirse a un aparato de receptor de ondas de radio, puede referirse a la medida de la distancia del centro del cirulo a su circunferencia, o incluso en una temática especializada puede referirse al tamaño del hueso del antebrazo llamado radio.

Ante tal frase la desambiguación solo puede realizarse mediante el resto de frases y el contexto del texto.

Si por el ejemplo la frase continuara: “Ese es un radio muy grande, debemos limitar mejor el área geográfica del estudio.” Es claro que la acepción de la palabra hace referencia a la distancia del centro del circulo a su circunferencia. Siendo así Google ofrecerá preferiblemente este resultados a patrones de búsqueda y conusltas que han mostrado intereses en estudios demográficos, geológicos, de mercado o similares.

Si por ejemplo la frase fuera: “En la siguiente radiografía del sujeto de estudio, podemos observar los huesos de la mano hasta el hombro y ver como ese es un radio muy grande” Es claro por su contexto que la palabra radio hace referencia a una temática ósea y médica. Bajo este concepto es de esperar que Google recomiende este resultados a cuentas con patrones de búsqueda médicos, veterinarios o similares.

Si por el contrario la frase fuera: El primer radio que compró la familia pesaba más de 5 Kilos y ocupaba la mitad de la pared de la sala, aún lo conservamos, ese es un radio muy grande. El contexto aclara que el sujeto es un radio de música. Dicho texto podría ser recomendado como resultado como parte de material de un autor, o una narración histórica por ejemplo. Podría ser añadido por BERT a un nombre de novela, autor o genero literario como resultado sugerido.

¿Cómo optimizo para BERT?

La recomendación general es no optimizar para BERT pues es un sistema de Deep Learning y una inteligencia artificial que evalúa millones de líneas de texto con regularidad y predice a tiempo real las consultas realizadas en Google. Sin embargo apegarse a las buenas prácticas de creación de contenido es una buena estrategia para facilitar que indexación correcta de nuestro contenido y sitio web dentro de los catálogos y categorías de BERT.

De manera que si nuestro público meta es público académico, científico o similar deberíamos utilizar temas términos y acepciones claras y exactas y proveer nuestro texto y contenido de un contexto relacionado directamente con los puntos que vamos a desarrollar.

Si nuestro público es un público casual o nuestro contenido se basa en el entretenimiento. Nuestro contenido debe de ser claro y precisos en sus referencias y contexto, aunque puede ser bastante más laxo en la exactitud de las terminologías.

Si nuestro público son compradores compradores deberíamos agregar descripciones precisas (extensas si es necesario) que puedan apelar a cualquiera de los valores y atributos que nuestros clientes potenciales puedan buscar en el producto.

Expresiones y geografía.

La capacidad de algoritmos como BERT de procesar grandes volúmenes de datos y texto en poco tiempo, implica que se ha podido especializar y levantar categorías de comportamientos lingüísticos basados en poblaciones, temáticas y locaciones geográficas. Es decir que ha sido entrando para poder captar expresiones propias de lugares y poblaciones. En lugares como américa latina donde el castellano es la lengua predominante BERT ha sido capaz de identificar las expresiones, acepciones, dichos y significados de las palabras.

Esto implica que muchos resultados son categorizados y entregados de manera regional. Por tanto diferentes sitos web aparecerán en los primeros resultados basados emparejar en el lenguaje usado para realizar la consulta con el estilo del escrito y contenido del sitio web.

Fuentes:

https://ai.googleblog.com/2018/11/open-sourcing-bert-state-of-art-pre.html

Mantente al día con el historial de cambios al Algoritmo de Google